大脑记忆系统研究取得重大进展:或被用于开发新的芯片和操作系统

索尔克研究所发布的数据表明,人脑记忆容量可达到PB级别,相当于整个互联网的数据量,这项研究也揭开了人脑高效节能之谜。发现也将有助于计算机科学家开发超精密的、高效节能的计算机,尤其是那些配置深度学习和人工神经网络的机器,这些程序能够胜任复杂的学习和分析,例如语音识别、图像识别和翻译。

索尔克研究所发布的数据表明,人脑记忆容量可达到PB级别,相当于整个互联网的数据量,这项研究也揭开了人脑高效节能之谜。发现也将有助于计算机科学家开发超精密的、高效节能的计算机,尤其是那些配置深度学习和人工神经网络的机器,这些程序能够胜任复杂的学习和分析,例如语音识别、图像识别和翻译。

从左开始: Terry Sejnowski, Cailey Bromer和Tom Bartol。

来自索尔克的研究人员和合作者在神经元连接规模的研究方面取得关键进展,研究结果表明,人类大脑的记忆容量要远远高于常见的估计。这项新研究也解答了一个长期问题,人脑为何如此高效节能,这将有助于工程师去研发性能异常强大且非常节能的计算机。

「这在神经科学领域真的是令人震惊的事情,」索尔克研究所教授和这篇论文的联合作者Terry Sejnowski说道,「海马神经元拥有强大的计算能力且仅需要较小的能量,我们找到了解锁它们设计原理的钥匙。我们对人脑记忆容量进行了新的测量,其容量比我们通常保守的估计值提高了十倍,至少能达到1PB,与整个互联网的信息容量相当。」

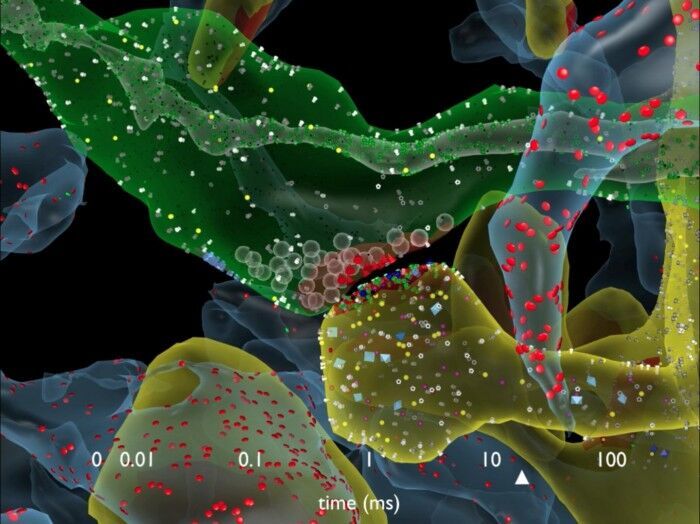

我们的记忆和思想是由大脑中的各种电化学活动模式所产生的。当像电线一样的神经元分支在特定连接点(也就是突触)相互作用时,就来到了神经元活动的关键环节。一个神经元的输出「电线」(轴突)会连接到另一个神经元的输入「电线」(树突)上。信号借助被称为神经递质的化学物质在突触间进行传递,来告诉接收神经元是否要将这个电信号传递给其他神经元。每个神经元都拥有成千上万个突触,每个突触又连接着其他成千上万个神经元。

How Synapses Work?点击视频观看

「我们从海马体中取出了相当于一个红细胞大小的部分,当首次对里面的每一个树突、轴突、胶质和突触进行重建时,突触内部的复杂性和多样性使我们有些不知所措,」论文联合作者及得克萨斯大学神经科学教授Kristen Harris说,「尽管我之前希望能够借助这些详细的重建来弄清大脑如何组织的基本原理,但当对这份报告进行分析之后,我对大脑的精密程度惊叹不已。」

突触依然是个谜,尽管它们的功能紊乱会引发一系列的神经疾病。更大的突触会拥有更多的表面积和包含神经递质的泡状体,它们会更强大,比起中小型突触,它们更容易被激活。

索尔克研究所的团队对老鼠的海马体组织(大脑的记忆中枢)做了3D重建,他们注意到了一些不同寻常的现象。有时候,一个神经元的轴突会与另外一个神经元的树突形成两个突触,这预示着第一个神经元好像又给接收神经元发送了一份副本信息。

研究者一开始没有特别重视这累「双重现象」,因为这在海马体中出现的概率是10%。但索尔克的一位研究员Tom Bartol却认为:如果他们能测量出这对相似突触之间的差异,那他们就有可能深入了解突触的尺寸,因为截至到目前为止,突触还是仅仅依靠大、中、小来分类。

突触

研究人员发现,实际上,这些突触按照尺寸可以分成26类,而不是像之前那样,只能分成大中小3类,每隔几分钟就会发生变化,也就是说,大脑有着强大得多的信息储存能力。

在对大脑海马体组织的虚拟创建中,索尔克和德克萨斯州大学奥斯汀分校的科学家们发现了这种不寻常的双突触现象。

为了完成这项任务,研究者使用了先进的显微镜和自己开发的算法来去老鼠的大脑进行成像,并从纳米分子级别上模拟重建了神经元的连接、形状、大脑组织的容量和表面积。

科学家团队此前预计突触的尺寸会大致类似,但非常奇怪地发现,所有的突触几乎完全一样。Bartol说:「我们发现一对突触的差异非常小,平均来说只有8%的差别,这让我们非常吃惊。没人想过它们的差异如此之小。但这就是大自然的刁钻之作。」

由于神经元的记忆容量取决于突触的大小,8%的差异成为一个关键数据,研究团队可以将这个数据输入到大脑的算法模型中,从而测量出突触连接所拥有的潜在的信息存储量。

以前大家一向认为最大的突触和最小的突触的差异范围是一个60的参数,大部分都很小。但现在我们知道了,所有突触的尺寸变化范围是围绕着8%,在60这个参数内,因此,这个研究团队断定,这些突触按照尺寸可以分成26类,而不是像之前那样,只能分成大中小3类。

「数据表明,现在突触的尺寸类别比之前提高了10倍。」Bartol说。按照计算机术语,26中不同尺寸的突触对应的信息存储容量大约为4.7比特。先前大家的观点是,大脑海马体中短期记忆和长期记忆存储容量只有1-2比特。

「大脑精度的数量级超出了此前所有人的想象,」Sejnowski说。这种精度令人疑惑的地方在于,海马体突触的不可靠众所周知。当信号从一个神经元传递到另一个神经元,当时仅激活第二个神经元的10%-20%。

我们过去经常疑惑于,大脑非凡的精度是如何从如此不可靠的突触中产生的?Bartol说。一个可能的答案是突触持续的适应活动,久而久之会将它们的成功率和失败率达到均衡。团队借助这些新数据和统计模型去发现多少信号能使一对突触抵消8%的差异。

研究者的计算结果表明,对于最小的突触,1500个事件会使它们的大小发生改变(大约20分钟),而对于最大的那些突触,仅需要100个信号事件就能使其改变(大约1-2分钟)。「这意味着,每隔2-20分钟,你的突触会向上或者向下变成下一个尺寸。突触会根据它们接收到的信号进行自我调整。」Bartol说。

也就是说,大脑会以2-20分钟为周期将突触的尺寸调整到平均值。突触越强大,它容易刺激下一个神经元。这26中不同尺寸的突触和多余的树突结合起来,使大脑能够在某一特定时刻优先设置神经网络,使大脑消耗更低的能量,因此,当面对相同任务时,大脑的能耗要比计算机低。

「我们先前的研究暗示了通过突触连接在一起的轴突和树突会有着相同的尺寸,但大脑精度的事实着实引发了我们的注意,这为从一个全新的角度去思考大脑和计算机奠定了基础,这项合作的研究成果为寻找大脑的学习和记忆机制开启了新篇章。」Harris说。他补充道,研究结果给我们带来了需要探索的新问题,比如说,这个规则是否适用于大脑其他区域的突触,以及随着突触在学习早期阶段的改变,这些规则将如何在发育过程中产生分化。

我们这项发现所带来的影响意义深远。Sejnowski补充到,看似混乱不堪的大脑内部其实隐藏着突触精确的尺度和形状,这些都隐藏了起来,不被我们所知。

这些发现也提供了一种对大脑令人惊讶的效率的有价值的解释。成人在清醒时大脑只需要20瓦特的持续功率——这相当于一只暗淡的灯泡所需要的耗能。索尔克研究所的发现也将有助于计算机科学家开发超精密的、高效节能的计算机,尤其是那些配置深度学习和人工神经网络的机器,这些程序能够胜任复杂的学习和分析,例如语音识别、图像识别和翻译。

Sejnowski说:「大脑的这个精妙之处毫无疑问的为我们提供了一种设计更好计算机的新方法,使用概率传输被证明是正确的,它需要较小的能耗,对于计算机和人脑都是如此。」「这是我们正在寻找的东西,」「随着芯片添加越来越多的晶体管,它们也会有更多的瑕疵。」

现在,计算机记忆的一个失败会导致整个系统功亏一篑。如果计算机能够吸取人脑从冗余中受益的原理,每个人工突触本质上是靠抛硬币决定是否传送信号,我们就能大幅度改善计算机能力。 Roland Memisevic 和 Yoshua Bengio已经开始探索这方面的可能性。

「Neural Networks with Few Multiplications」

摘要:众所周知,大多数深度学习算法训练非常耗费时间。既然训练神经网络过程中的大多数计算典型地将时间花在了浮点乘( floating

point multiplications)上,我们研究出一种训练方法,它能消除对所有这些的需要。我们的方法由两部分组成:

第一,随机二进制化权重(binarize weights),将与计算隐藏状态有关的乘转换为符号改变(sign changes)。

第二,当BP误差求导时,除了二进制化权重(binarizing the

weights),我们量化了每一层表征,将剩余的乘转换为二进制变化(binary

shifts)。经由3个流行数据组(MNIST,CIFAR10,SVHN)的实验结果表明,这一方法不仅没有损伤分类表现,而且能取得比标准的随机梯度下降训练更好的表现,为快速、硬件友好的神经网络训练铺平了道路。作者:Zhouhan Lin, Matthieu Courbariaux, Roland Memisevic, Yoshua Bengio

Sejnowski说,「这是一个全新的计算机结构,最终会被用于开发新的芯片和操作系统,这一新系统不再以完美的、确定性数字计算机操作为基础,而是建立在概率( probability)基础上。」他补充说,训练神经网络能够启发我们如何研究大脑。「很有意思,我们研究已经发展到大脑理论正与计算机理论密切互动的程度。」

本文转载自:http://www.huxiu.com/article/138880/1.html。原文选自salk和CIFAR,机器之心编译出品,参与:赵云峰,微胖。转载请联系公众号:机器之心(almosthuman2014)获得授权,个人微信号“jiqizhixin2014”。本文仅作收录之用,并不做对外传播用。

更多推荐

已为社区贡献35条内容

已为社区贡献35条内容

所有评论(0)